Quest 3的开发人员现在可以整合三项重大新功能,以改善虚拟和混合现实体验。

Quest 3宣布12月份推出的Inside-Out Body Tracking(IOBT)和生成式Legs随后发布。在此之前,混合现实通过Depth API实现的遮挡功能曾是实验性功能,这意味着开发人员可以进行测试,但不能在Quest Store或App Lab构建中发布。

这三项功能都作为Unity和本机代码的v60 SDK的一部分可用。与此同时,v60 Unreal Engine集成包括了Depth API,但不包括IOBT或生成式Legs。

Inside-Out Upper Body Tracking

Inside-Out Body Tracking(IOBT)使用Quest 3的侧置摄像头,该摄像头面向下方,使用先进的计算机视觉算法,可跟踪手腕、肘部、肩膀和躯干。

IOBT可以避免反向动力学(IK)估计的手臂问题,因为从头部和手部的位置仅进行猜测,通常不准确且感觉不舒服。当开发人员整合IOBT时,你将看到手臂和躯干处于其实际位置,而不是一个估计位置。

这种上半身跟踪还使开发人员可以将拇指杆定位到你的身体方向上,而不仅仅是头部或手部的方向,并且您可以执行新的动作,比如倾斜到悬崖边并在您的角色模型中以逼真的形式显示出来。

AI Generative Legs

IOBT仅适用于你的上半身。为了下半身,Meta推出了Generative Legs。

Generative Legs使用“尖端”的AI模型估计你的腿部位置-这是该公司多年来进行研究的技术。

在Quest 3上,由于使用上半身跟踪作为输入,Generative Legs提供了比之前头显更真实的估计,但也可以在Quest Pro和Quest 2上只使用头部和手部。

Generative Legs系统只是一个估计器,而不是跟踪器,因此虽然它可以检测跳跃和蹲下等动作,但不会捕捉到许多实际的运动,比如抬膝盖。

内置的上半身跟踪和Generative Legs可实现虚拟现实中可信的全身,称为全身综合,无需外部硬件。

Meta此前宣布,全身综合将应用到Supernatural、Swordsman VR和Drunken Bar Fight中。

Depth API For Occlusion In Mixed Reality

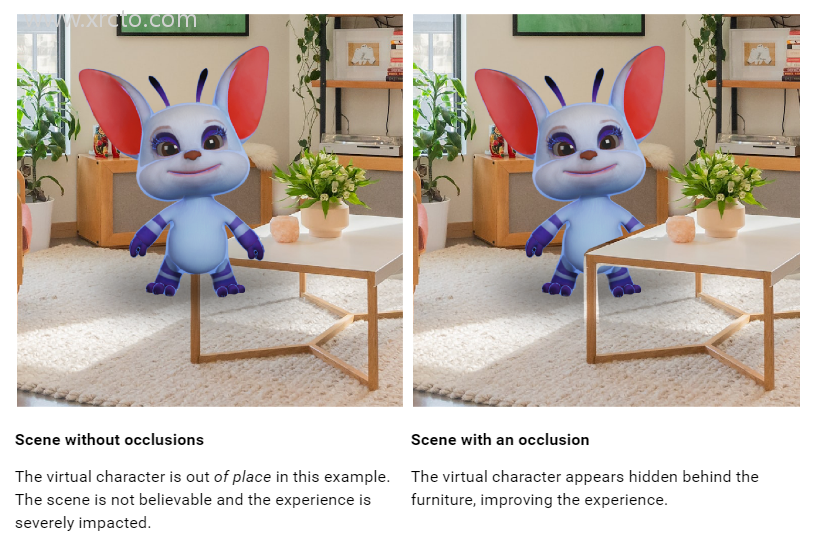

在我们的Quest 3评测中,我们严厉批评了缺乏混合现实动态遮挡。虚拟对象可以出现在空间网格背后,但它们总是显示在移动对象(例如手臂和其他人)的前面,即使距离更远,这看起来令人不舒服且不自然。

开发人员可以使用手部跟踪网格实现手部的动态遮挡,但很少有人这样做,因为它只限制于手腕,因此手臂的其余部分没有被包括在内。

新的Depth API为开发人员提供了由头戴显示器从其视角生成的每帧粗略深度图。这可以用于实现遮挡,包括移动对象和静态对象的更细节的遮挡,因为这些可能没有在场景网格中被捕捉到。

动态遮挡应该能让Quest 3上的混合现实看起来更自然。然而,头戴显示器的深度感应分辨率非常低,它不会捕捉到手指之间的空间,并且你将在物体边缘看到一个空隙。

深度图仅建议使用到4米之外,之后“准确度显著下降”,因此开发人员可能还想使用场景网格进行静态遮挡。

开发人员可以通过两种方式实现遮挡:硬和软。硬的实现基本上是免费的,但边缘会有锯齿状;而软的实现需要GPU成本,但效果更好。从Meta的示例剪辑来看,很难想象会有开发人员会选择硬遮挡。

但不管哪种情况,遮挡都需要使用Meta的特殊遮挡着色器或在自定义着色器中专门实现。这远非一键解决方案,开发人员支持这一功能可能需要巨大的工作量。

除了遮挡之外,开发人员还可以使用Depth API在混合现实中实现基于深度的视觉效果,比如大雾。

您可以在这里找到Unity的文档和Unreal的文档。