Meta Quest 平台的最新 SDK 版本 v74 带来了令人兴奋的新功能,包括拇指微手势和改进的“音频到表情”技术,进一步提升了 VR 交互的自然性和真实感。

此次更新还包含了用于访问透视摄像头功能的辅助工具。此前,Meta 刚刚向开发者开放了这一权限,允许应用程序在获得用户许可后访问头显前置彩色摄像头,并获取包括镜头参数和头显姿态等Meta,从而能够运行自定义的计算机视觉模型。这为开发者在 VR 环境中实现更丰富的视觉交互创造了可能性。

拇指微手势:更便捷的 VR 交互方式

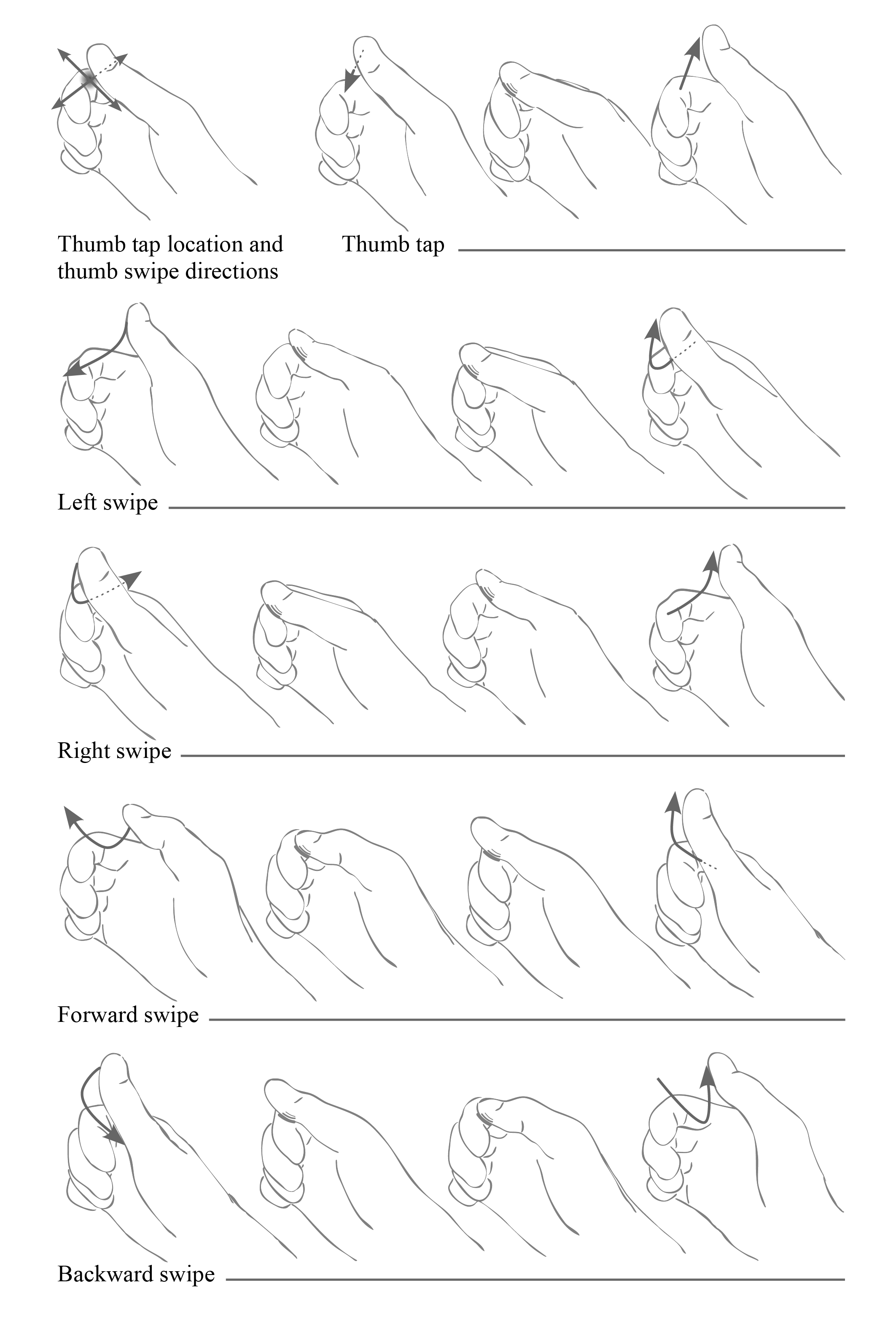

拇指微手势充分利用了 Quest 头显的无控制器手部追踪技术,能够检测用户拇指在食指上的轻敲和滑动动作。当手掌侧向弯曲,手指蜷起时,这些微小的动作会被识别为类似 Steam Controller D-pad 的输入操作。这种创新性的交互方式,有望在 VR 体验中带来更便捷的操作体验。

对于 Unity 引擎,微手势功能需要 Meta XR Core SDK 的支持。而在其他引擎中,开发者可以通过新的 OpenXR 扩展 XR_META_hand_tracking_microgestures 来实现类似的功能。

Meta 官方表示,这些微手势可以用于实现无需控制器的传送和转向等操作。但实际上,微手势的具体应用方式完全取决于开发者的创意和实现。这意味着,开发者可以根据不同的应用场景,探索微手势的更多可能性。

例如,开发者可以利用微手势来减少用户在界面导航时的体力消耗,避免用户需要不断伸出手臂或指向元素。想象一下,通过简单的拇指滑动,就能轻松浏览复杂的菜单,这无疑将大大提升 VR 体验的舒适度和便捷性。

有趣的是,Meta 还在其正在开发的神经腕带(未来 AR 眼镜的输入设备)中采用了类似的拇指微手势技术。据报道,该技术也可能应用于 Meta 计划在今年晚些时候推出的 HUD 眼镜中。这表明,Meta 正在积极探索微手势在各种设备上的应用前景。

这暗示着 Quest 头显可以作为一个开发平台,用于开发这些未来的眼镜,并充分利用拇指微手势技术。当然,要完全匹配 Orion 原型的全部输入能力,还需要加入眼球追踪功能。

改进的“音频到表情”:赋予虚拟人物更生动的表情

“音频到表情”是 Meta 在 SDK v71 版本中引入的设备端 AI 模型。它能够仅通过麦克风音频输入生成逼真的面部肌肉运动,从而在无需面部追踪硬件的情况下,估计用户的面部表情。这项技术为 VR 应用带来了更自然的社交互动。

“音频到表情”取代了使用了十年的 Oculus Lipsync SDK。之前的SDK仅支持嘴唇动作,而无法模拟其他面部肌肉的运动。Meta 声称,“音频到表情”实际上比 Oculus Lipsync 消耗更少的 CPU 资源,实现了性能和效果的双重提升。

此次 v74 版本中,Meta XR Core SDK 带来了一个经过升级的模型,官方表示该模型“在情感表达、嘴部动作以及非语音发声的准确性等方面都得到了改进,相比之前的模型更加出色”。这意味着,虚拟人物将拥有更生动的表情,从而提升 VR 体验的沉浸感和真实感。

值得注意的是,Meta 自己的 Avatars SDK 仍然没有使用“音频到表情”技术,也没有采用由内向外的身体追踪技术。未来是否会采用这些技术,还有待进一步观察。尽管如此,Quest SDK 的不断更新和功能增强,无疑为 VR 开发者提供了更多可能性,也为用户带来了更优质的 VR 体验。