(XR Navigation Network 2024年05月23日)视频会议已经成为人们联系的主要方式。从工作电话到虚拟欢乐时光,从网络研讨会到在线剧院,当人们看到其他参与者时,他们会感到更紧密地联系在一起,使得更接近面对面体验。然而,视频通话依然是对面对面交流的苍白模仿。

人工现实系统可以为用户提供参与3D呼叫的能力,其中呼叫参与者可以看到一个或多个其他呼叫参与者的3D表示。在这样的3D通话中,用户体验更接近于模拟面对面互动。

对于3D通话,一个重要的因素是双眼的逼真呈现。所以在名为“Authentic eye region capture through artificial reality 头显”的专利申请,Meta提出了通过XR头显提供真实的眼睛区域呈现。

图4示出组件400的框图。眼捕捉触发事件识别模块436可以基于时间多路复用定时器模块438识别眼捕捉触发事件。时间多路复用定时器模块438可以是在XR头显和外部图像捕获设备之间同步的定时器。

照明效果停用模块442可以响应眼睛捕获触发事件,在一段时间内调整和/或停用至少一种照明效果。例如,照明效果停用模块442可以在很短的时间内减少XR头显透镜的照明或关闭XR头显透镜的着色。

眼捕捉触发事件识别模块436可以基于由周期触发模块440生成的周期触发来识别眼捕捉触发事件。周期触发器模块440可为XR头显生成周期触发器。周期触发器模块440可以以相等的间隔,例如,每2秒产生周期触发器。周期触发器模块440可以基于事件的发生生成周期触发器。例如,周期触发模块440可以与指向XR头显用户眼睛的图像捕获设备相关联,检测用户眼睛和/或眼睛区域的运动并生成周期触发。照明效果停用模块442可响应于眼球捕获触发事件,在一时间段内停用至少一种照明效果。

图5示出了过程500的流程图。

在502,流程500可以通过在XR头显透镜应用至少一种照明效果来显示XR体验。在一个实施例中,XR体验可以是全息通话,其中戴着XR头显的呼叫发送方可以通过应用的照明效果看到代表接听方的全息图,反之亦然。

在504,进程500可以识别一个眼捕捉触发事件。进程500可以基于在XR头显和外部图像捕获设备之间同步的临时多路定时器识别眼球捕获触发事件。

在506,处理500可以响应所述眼捕获触发器,在一时间段内停用所述至少一种照明效果。例如,流程500可以在短时间内关闭XR头显透镜的照明和/或着色。时间段可以是人眼无法察觉,例如25ms或更短,但又足够长,使得眼睛的图像可以由外部图像捕获设备捕获,例如,1ms或更长。

图6A示出过程600A的流程图。如图6A所示,可以通过XR头显602、外部图像采集设备603和XR头显604来执行处理600A。外部图像捕获设备603可以捕获佩戴XR头显用户的图像,以便生成全息图数据。当XR体验是全息通话时,外部图像捕获设备603可以捕获呼叫发送方的图像,用于生成代表呼叫发送方的全息图。

在606,XR头显602可以应用至少一种照明效果来显示XR体验。在这样的实施例中,XR头显602可以向佩戴XR头显602的发送呼叫参与者显示接收呼叫参与者的全息图或其他表示。

在608,XR头显602可以识别基于与XR头显602或在与XR头显602进行通信的同步时间多路复用定时器积分的眼捕获触发事件。同时在610,外部图像捕获设备603可以基于与外部图像捕获设备603进行通信,或与外部图像捕获设备603进行通信的相应同步时间多路复用定时器积分来识别相应的眼捕获触发事件。另外,XR头显602和外部图像捕获设备603的临时多路定时器可以彼此处于操作通信中,使得它们可以同步。

在618,XR头显602可以在一段时间内停用至少一种照明效果。在同一时间段的622,外部图像采集设备603可以通过XR头显602的镜头捕获用户的眼睛区域。

在624,XR头显604响应接收与XR头显602相关联的用户的全息图数据,可以呈现XR头显602的用户的表示,包括由外部图像捕获设备603捕获的眼睛区域。具体来说,XR头显604可以将压缩后的数据转换回原始数据的一个版本。

图6B示出进程600B的流程图。

在606,XR头显602可以通过在XR头显602的透镜应用至少一种照明效果来显示XR体验。在616,XR头显602可以识别基于周期性触发器的眼球捕获触发事件。

在618,XR头显602可以在一段时间内停用至少一种照明效果。在622,外部图像采集设备603可以通过XR头显602的透镜捕获用户的眼睛区域。

图7A说明在未捕获用户眼睛区域时全息呼叫的示例700A。在示例700A中,用户704正在与另一个用户进行全息呼叫,其中用户的表示702出现在与用户704相同的空间中。

在图7A中,图示702用阴影表示,以表明它是全息图。通过头显752投射到用户704的眼睛中,用户704可以看到表示702。因此,如果没有XR设备,表示702将不会对空间中的其他人可见。在全息呼叫中,使用彩色和/或深度摄像头,通过外部图像捕获设备754捕获用户704的彩色和/或深度图像,如折线所示。由此,创建用户704的表示,并将其显示给表示为702的接收用户。头显752同时可以捕获音频,并同步并传输到接收用户,以便与发送用户的表示同时输出。

在示例700A中,头显752的透镜706A将一种或多种照明效果应用于镜头706A,以便在全息呼叫中查看接收用户的表现702。这种照明效果的应用会导致透镜706A显得不透明、明亮和/或暗,使得外部图像捕获设备754不能准确地捕获用户704的眼睛区域。因此,创建用户704的表示并将其显示给接收用户,而没有对用户704的眼睛区域的准确描述。

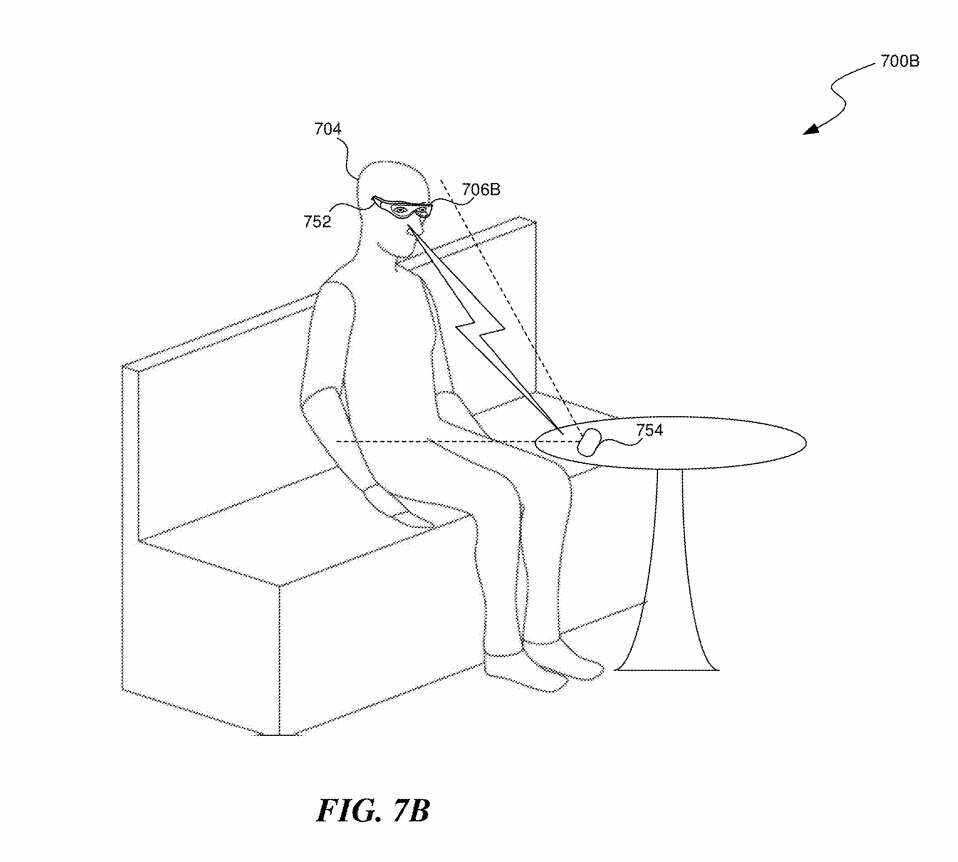

图7B是说明在捕获用户眼睛区域时全息呼叫的示例700B。在实施例700B中,用户704仍然与另一用户进行全息呼叫。

但在示例700B中,头显752调整和/或禁用了应用于透镜706B的一个或多个照明效果。例如,头显752可以调整、禁用和/或停用透镜706A的一种或多种着色、来自LED阵列或其他照明源的光输出、调整光栅等的一种或多种着色等等。

在一个实施例中,时间周期可以足够短,以至于用户704的肉眼无法察觉表示702的消失,例如25ms或更短。通过调整和/或停用应用于透镜706B的一种或多种照明效果,透镜706B可以在短时间内变得“透视”,例如半透明或透明。

头显752可以包括与设备254中包含的相应的临时多路复用定时器同步的临时多路复用定时器。外部图像捕获设备754可以是基于事件的摄像头,其检测由一个或多个照明效果的调整和/或停用引起的透镜706B中的像素变化。

因此,当头显752调整和/或停用应用于透镜706B的一种或多种照明效果时,设备254可以同时通过透镜706B捕获用户704眼睛区域的图像。然后,可以创建用户704的表示,并将具有眼睛区域准确描述的用户表示显示给接收用户。

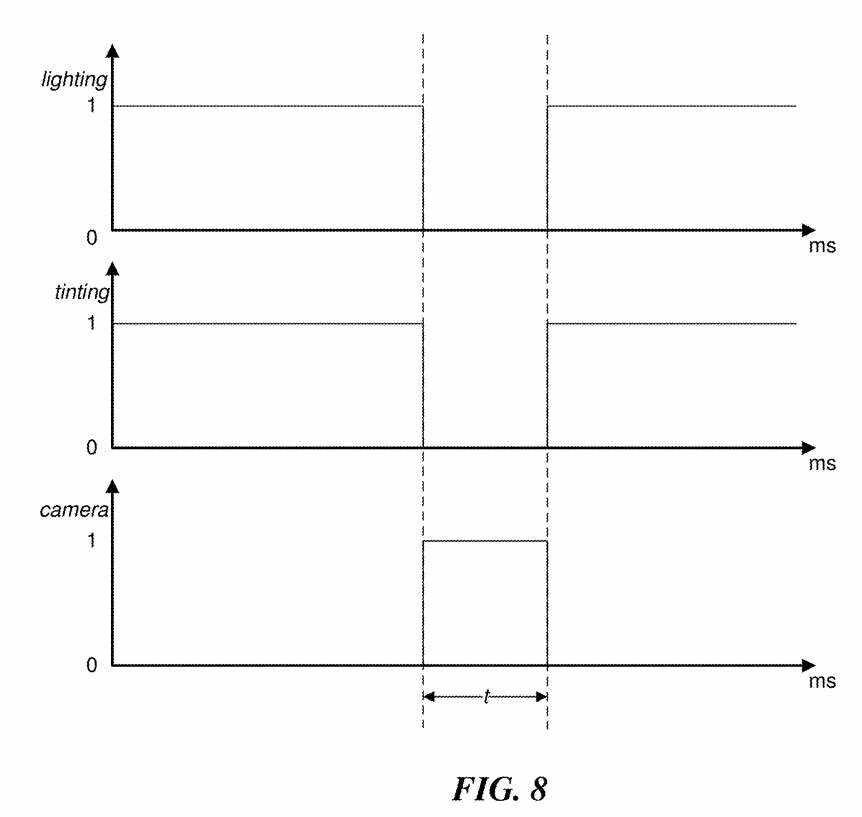

图8显示了XR头显关闭应用于其透镜的照明效果,以及同时捕获用户眼睛区域图像的外部图像捕获设备。

图800包含了两种可以应用于XR头显镜头的照明效果的插图,即照明和着色。XR头显可以对XR头显的镜头进行照明和着色,以向XR头显的用户显示XR体验,如值“1”所示,表示这些功能已打开。在一段时间内,XR头显可以停用照明和着色效果,如数值“0”所示,表示这些功能已关闭。在同一时间段t内,外部图像捕获设可以捕获XR头显用户的眼睛区域,如值“1”所示,表示正在捕获眼睛区域。

图9是示出数据转换的示例900的概念图,从原始捕获的数据到用户的全息表示,通过使用捕获的用户眼睛区域进行面部重建。图902说明了原始捕获数据,其中XR头显921透镜阻挡了外部图像捕获设备图像数据。

图904示出原始图像致密化的结果。由于致密化,伪影914、916已被纠正,XR头显透镜后面的深度数据920已被填充,并添加了额外的深度数据(未显示)。

图906显示了进行面部重建的进一步变换。这种面部重建用数据922填补了空白918,并使用外部设备捕获的一个或多个图像澄清和增强了XR头显921透镜后面的眼睛区域923的数据。

因此,图像906可以包括在特定时间点的眼睛区域的准确描绘。

名为“Authentic eye region capture through artificial reality 头显”的Meta专利申请最初在2022年8月提交,并在日前由美国专利商标局公布。

Related posts